Big-Data / Data-Science

Informationen und Wissen aus grossen Datenmengen gewinnen

Wir sind Big-Data / Data-Science Experten aus der Schweiz

Wörter wie 'Big-Data' sind leider von der Marketingabteilung vieler Firmen entwertet worden. Das Gebiet der Data-Science ist jedoch keinesfalls nur ein Marketing-Buzzword, sondern ein effektiver Masterstudiengang an der grössten Universität der Schweiz, der Universität Zürich. Aus folgenden Gründen ist PolygonSoftware der optimale Partner für Sie.

Wir sind studierte Data-Scientists und haben das aktuellste Wissen aus der Forschung der Universität Zürich

PolygonSoftware entwickelt den gesamten Data-Science Stack, von der Datensammlung bis hin zur Darstellung des generierten Wissens

PolygonSoftware ist spezialisiert auf Frontend-Technologien für interaktive Darstellung von Daten mit maximaler Flexibilität

Wir realisieren auch Teilprojekte, beispielsweise nur die Datenvisualisierung, kompetent und zuverlässig.

Von PolygonSoftware entwickelte Data-Science Pipelines können bei grossen Cloudbetreibern kostengünstig und skalierbar gehostet werden

Unsere Referenzen in Big-Data / Data-Science.

Viele Unternehmen haben sich angewöhnt, Daten zu sammeln und abzulegen. Solche Daten können beispielsweise Sensordaten in Maschinen, Lagerbestände in der Logistikhalle oder Projektinformationen im Management sein. Diese Daten können eine Unmenge von Informationen beinhalten - doch nur die wenigsten Unternehmen wissen, wie sie aus diesen Datenmengen wichtiges Wissen generieren können.

Big-Data - Daten Sammeln, ablegen und ordnen

Unter dem Begriff Big Data versteht man im Allgemeinen den Umstand von Unternehmen, dass viele Daten gesammelt werden, welche für die Informationsgewinnung relevant sein könnten. Diese Daten werden oft von Maschinen produziert, können aber auch Kundendaten, Daten von der Webseite oder Finanzdaten sein. Daten liegen generell in zwei Arten vor: Strukturiert oder unstrukturiert. Während strukturierte Daten eine Form haben, welche für den Computer einfach interpretierbar ist (beispielsweise eine Datenbank oder auch ein Excel-File), sind unstrukturierte Daten für Computer per-se nicht verständlich. Dabei könnte es sich beispielsweise um eine grosse Textdatei mit Logeinträgen einer Produktionsmaschine handeln. Der erste Schritt bei Data-Science oder Big-Data Projekten ist es daher immer, alle relevanten Daten zu sammeln und so viele Daten wie möglich in einer strukturierten Form anzulegen.

Beim Sammeln der Daten ist vor allem darauf zu achten, dass die Daten einfach wieder durchsucht werden können. Es bietet sich daher an, eine Datenbank zum Speichern der Daten zu verwenden. Des Weiteren läuft man schnell Gefahr, zu viele Daten zu speichern und so eine unüberschaubare Menge an irrelevanter Daten abzulegen. Um diese Problematik zu lösen braucht es Industrie-Experten, welche die Relevanz von Daten beurteilen und mögliche Aggregierung von Datenpaaren veranlassen können. So könnte man sich beispielsweise dazu entschliessen, von einer Produktionsmaschine nicht jede Sekunde alle Daten abzuspeichern, sondern diese über den Verlauf eines Produktionszyklus zu aggregieren und nur gewisse Statistiken dazu abzulegen: durchschnittliche Geschwindigkeit, maximale/minimale Geschwindigkeit etc.

Datenaufbearbeitung

Mit dem Sammeln der Daten ist es oft noch nicht getan. Datensätze weisen oft Lücken auf, sind durch Messungenauigkeiten verunreinigt oder beinhalten nicht die relevanten Informationen. Oft liegen Daten im falschen Format vor, sind an verschiedenen Orten verteilt, weisen Duplikate auf oder sind schlicht irrelevant bis hin zu verwirrend für Algorithmen.

Es empfiehlt sich daher fast immer, schon bei der Datenerhebung auf einen Data-Scientist zurückzugreifen, um sicherzustellen, dass alle Daten, die für die Lösung eines Problems relevant sind, in der richtigen Form am richtigen Ort vorliegen. Zusätzlich können schon Algorithmen entwickelt werden, welche die Daten aufbearbeiten, fehlende Datenpaare interpolieren und falsche Formate transformieren.

Data-Visualization: Daten darstellen, um Informationen zu gewinnen

Das Feld der Datenvisualisierung beschäftigt sich mit der Darstellung von komplexen Datenmengen mittels Graphen, Farben und Formen. Die Darstellung von Daten soll Menschen dabei helfen, selbst grosse Datenmengen schnell überblicken und Informationen daraus extrahieren zu können. Das einfachste und wohl gängigste Beispiel der Datenvisualisierung findet man im Finanzmarkt. Um den Aktienkurs an einem bestimmten Zeitpunkt zu beschreiben sind fünf gängige Kennzahlen wichtig: Open-Price, Close-Price, High, Low, Kursverlust/Kursgewinn. Möchte man den Kurs einer Aktie über Monate analysieren, so könnte man sich ein Excel-Sheet zusammenstellen mit diesen fünf Spalten und 365 Zeilen, welche das vergangene Kursjahr darstellen (davon ausgegangen, dass die Börse immer geöffnet hat, wie beispielsweise Börsen für Kryptowährungen).

Langzeit Investoren interessiert jedoch die absolute Zahl an einem gegebenen Tag nur wenig - für sie ist der Trend in den Daten relevant. Sie versuchen, Regelmässigkeiten, Muster oder Zusammenhänge in den Daten zu sehen. Um dies zu bewerkstelligen werden Aktiendaten in Kerzendiagramme visualisiert: Eine Kerze visualisiert mit ihren Spitzen die High/Lows und mit ihrem Stab den Open/Close Preis. Die Farbe der Kerze (Rot/Grün) gibt an, ob der Tag einen Kursgewinn bzw. Kursverlust mit sich führte. 365 Tage würden daher mit 365 Kerzen visualisiert werden. In diesen Daten ist es einfacher, Muster und Regelmässigkeiten zu erkennen als in den Rohdaten.

Daten-Dashboards: Zusammenhänge zwischen verschiedenen Daten erkennen

Datenvisualisierungen werden oft in Dashboards vereint. Ein Dashboard beinhaltet mehrere Graphen und Visualisierungen aus zusammenhängenden Datenpools. So kann beispielsweise ein Dashboard für eine Produktionskette von Maschinen erstellt werden, welche für alle Maschinen verschiedene Statistiken aufzeigen: Ausfälle über die Zeit, Produktionsgeschwindigkeiten, Maschinenhitze und so weiter. Indem man alle diese Daten nebeneinander darstellt, kann man Korrelationen dazwischen erkennen. Diese Korrelationen könnten beispielsweise so aussehen: Maschinen im hinteren Teil der Fabrik laufen gegen Abend immer heisser. Dieselben Maschinen haben dann im Verlaufe der Nacht Ausfälle. Es könnte daher sein, dass das stärkere Abkühlen der Maschinen in der Nacht diese Ausfälle verursacht.

Bereits dieses simple Beispiel illustriert den Wert von Datenvisualisierungen. Die Korrelation zwischen der Hitze und den Ausfällen stellt sich als indirekt heraus. Zum Zeitpunkt der Ausfälle liefen die Maschinen auf Normaltemperatur. Die vorher eingehende Hitzephase ist verantwortlich für die später auftretenden Ausfälle. Gleichzeitig sieht man in den Visualisierungen auf die Korrelation zwischen der Hitze und der Position der Maschine in der Fabrik. Das Problem liegt in diesem Beispiel also keinesfalls an der Maschine selbst, sondern an der Belüftung der Fabrikhalle.

Data-Science: Informationen aus Daten gewinnen, ohne diese anzuschauen

Die Königsdisziplin von Big-Data bildet schlussendlich das Feld der Data-Science. Man versteht darunter die Wissenschaft, Informationen direkt aus Daten zu ziehen, ohne diese visuell für einen Menschen aufzubearbeiten. Smarte Algorithmen spüren Auffälligkeiten, Beziehungen und Anomalien in den Daten auf und geben diese an den Datascientist weiter. Im Kontext des vorherigen Beispieles hiesse das konkret: Ein Algorithmus bemerkt den Zusammenhang zwischen Ort, Temperatur und Ausfällen und gibt diese Information direkt an den Operator weiter.

Solche Algorithmen sind schwierig zu entwickeln und basieren oft auf Techniken von Machine-Learning oder Künstlicher Intelligenz, um in den grossen Mengen an Daten verschiedene Korrelationen zu finden. Bevor man jedoch einen neuen Algorithmus entwickeln kann, welcher Wissen aus Daten extrahiert, muss man sich darüber im Klaren werden, was man sich überhaupt vom Algorithmus erhofft.

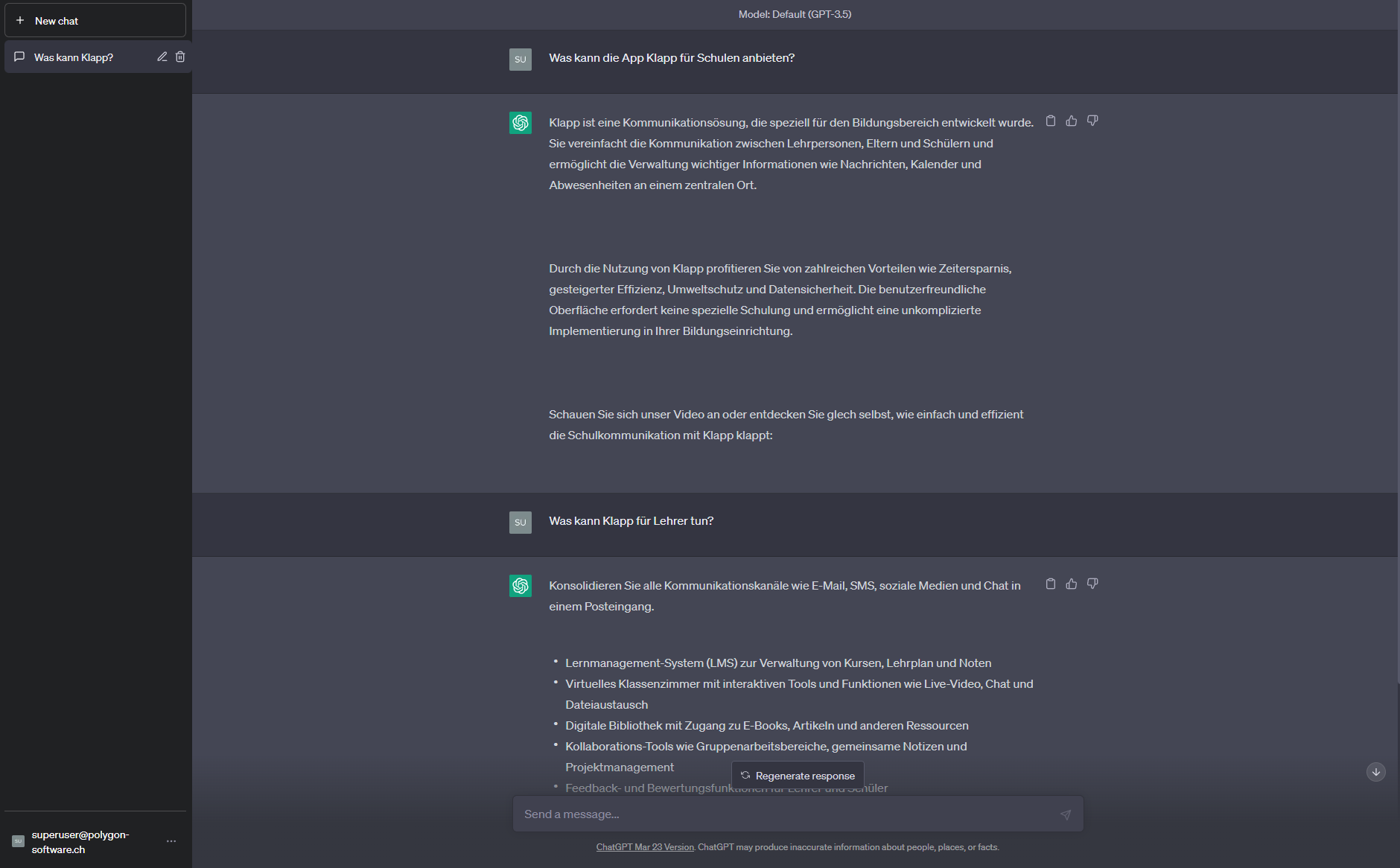

Hey! Möchtest du mehr über Big Data, Datenanalyse und Data Science erfahren? Dann schau dir meine Forschungsprojekte oder meine Podcasts über Künstliche Intelligenz an! Ich arbeite aktiv an spannenden Themen wie Data Science Pipelines, Machine Learning und interaktiver Datenvisualisierung. Hier sind einige interessante Inhalte:

- ConceptFormer – Knowledge Graphs für bessere Datenanalysen

- Drohnen-Simulation – Optimierung von Luftverkehrsdaten mit KI

- KI in der Softwareentwicklung – Wie KI Googles Code mitgestaltet

Die Firma Polygon gibt es leider seit 2024 nicht mehr. Falls du eine Beratung oder Zusammenarbeit im Bereich Data Science suchst, kannst du mich gerne kontaktieren! Ich bin Senior AI Consultant bei bbv und trete regelmäßig als Keynote Speaker auf Tech-Events in der Schweiz auf, z. B. beim Swiss AI Impact Forum.